اس بلاگ میں، ہم ان طریقوں پر توجہ مرکوز کریں گے جن سے آپ PyTorch میں GPU کے استعمال کو بڑھا سکتے ہیں۔

PyTorch میں GPU کے استعمال کو کیسے بڑھایا جائے؟

ایسی کئی تکنیکیں ہیں جن کا استعمال GPU کے استعمال کو بڑھانے اور اس بات کو یقینی بنانے کے لیے کیا جا سکتا ہے کہ پیچیدہ مشین لرننگ ماڈلز کی پروسیسنگ کے لیے ہارڈ ویئر کے بہترین وسائل استعمال کیے جا رہے ہیں۔ ان حربوں میں کوڈ میں ترمیم کرنا اور PyTorch کی خصوصیات کو استعمال کرنا شامل ہے۔ کچھ اہم نکات اور چالیں ذیل میں درج ہیں:

- ڈیٹا اور بیچ سائز لوڈ ہو رہا ہے۔

- کم میموری پر منحصر ماڈل

- پائی ٹارچ لائٹننگ

- Google Colab میں رن ٹائم کی ترتیبات کو ایڈجسٹ کریں۔

- اصلاح کے لیے کیشے صاف کریں۔

ڈیٹا اور بیچ سائز لوڈ ہو رہا ہے۔

' ڈیٹا لوڈر پی ٹارچ میں ڈیپ لرننگ ماڈل کے ہر فارورڈ پاس کے ساتھ پروسیسر میں لوڈ کیے جانے والے ڈیٹا کی تصریحات کی وضاحت کے لیے استعمال کیا جاتا ہے۔ ایک بڑا ' بیچ کا سائز ڈیٹا کے زیادہ پروسیسنگ پاور کی ضرورت ہوگی اور دستیاب GPU کے استعمال میں اضافہ ہوگا۔

PyTorch میں ایک مخصوص بیچ سائز کے ساتھ ڈیٹا لوڈر کو کسٹم متغیر کو تفویض کرنے کا نحو ذیل میں دیا گیا ہے:

Increase_GPU_Utilization = ڈیٹا لوڈر ( بیچ_سائز = 32 )

کم میموری پر منحصر ماڈل

ہر ماڈل کے فن تعمیر کے لیے مختلف حجم کی ضرورت ہوتی ہے۔ یاداشت 'اس کی بہترین سطح پر کارکردگی کا مظاہرہ کرنا۔ وہ ماڈل جو فی یونٹ وقت کی کم میموری استعمال کرنے میں کارآمد ہوتے ہیں وہ بیچ سائز کے ساتھ کام کرنے کے قابل ہوتے ہیں جو دوسروں سے کہیں زیادہ ہوتے ہیں۔

پائی ٹارچ لائٹننگ

PyTorch کا چھوٹا ورژن ہے جو کہ ' پائی ٹارچ لائٹننگ ' یہ بجلی کی تیز رفتار کارکردگی کے لیے موزوں ہے جیسا کہ اس کے نام سے دیکھا جا سکتا ہے۔ لائٹننگ بطور ڈیفالٹ GPUs استعمال کرتی ہے اور مشین لرننگ ماڈلز کے لیے بہت تیز پروسیسنگ پیش کرتی ہے۔ لائٹننگ کا ایک بڑا فائدہ بوائلر پلیٹ کوڈ کی ضرورت کی کمی ہے جو پروسیسنگ میں رکاوٹ بن سکتی ہے۔

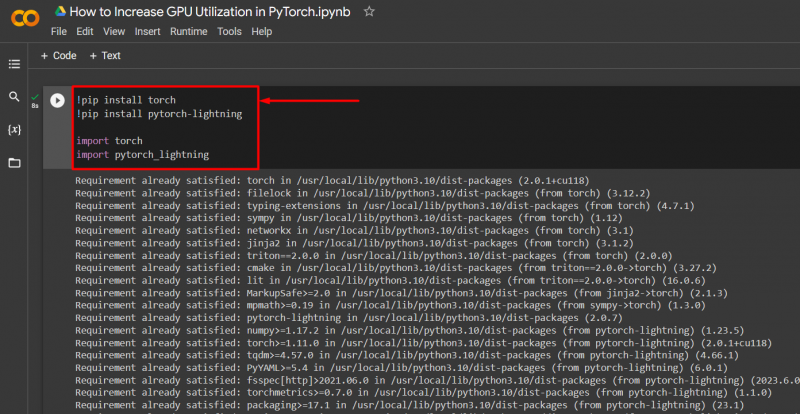

ضروری لائبریریوں کو ایک PyTorch پروجیکٹ میں درج ذیل نحو کے ساتھ درآمد کریں:

! پائپ انسٹال ٹارچ

! pip install pytorch - بجلی

درآمد ٹارچ

درآمد pytorch_lightning

Google Colab میں رن ٹائم کی ترتیبات کو ایڈجسٹ کریں۔

Google Colaboratory ایک کلاؤڈ IDE ہے جو اپنے صارفین کو PyTorch ماڈلز کی ترقی کے لیے مفت GPU رسائی فراہم کرتا ہے۔ بطور ڈیفالٹ، Colab پروجیکٹس CPU پر چل رہے ہیں لیکن ترتیبات کو تبدیل کیا جا سکتا ہے۔

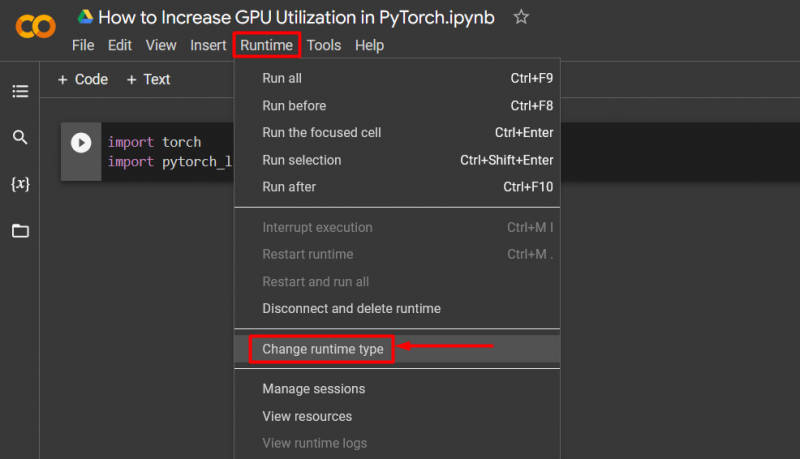

کولاب نوٹ بک کھولیں، 'پر جائیں رن ٹائم 'مینو بار میں آپشن، اور نیچے سکرول کریں' رن ٹائم کی ترتیبات کو تبدیل کریں۔ ”:

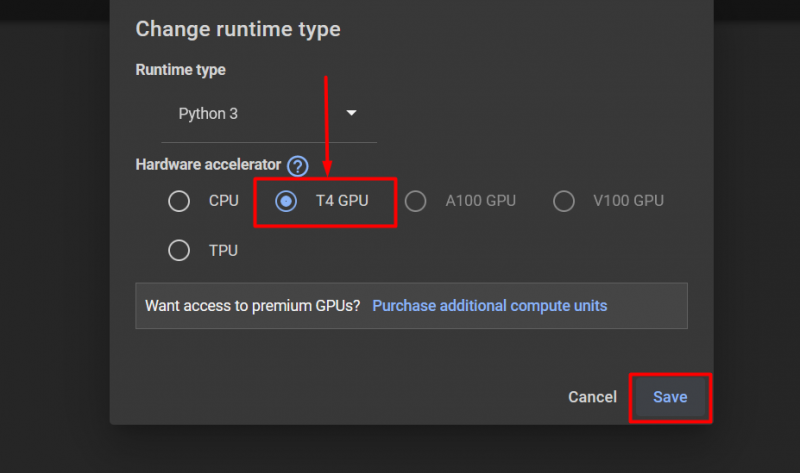

پھر، منتخب کریں 'T4 GPU' آپشن اور 'پر کلک کریں محفوظ کریں۔ GPU استعمال کرنے کے لیے تبدیلیاں لاگو کرنے کے لیے:

اصلاح کے لیے کیشے صاف کریں۔

PyTorch اپنے صارفین کو میموری کیش کو صاف کرنے کی اجازت دیتا ہے تاکہ نئے عمل کو چلانے کے لیے جگہ خالی کر سکے۔ ' کیشے ” چلائے جانے والے ماڈلز کے بارے میں ڈیٹا اور معلومات کو اسٹور کرتا ہے تاکہ یہ ان ماڈلز کو دوبارہ لوڈ کرنے میں خرچ ہونے والے وقت کی بچت کر سکے۔ کیشے کو صاف کرنے سے صارفین کو نئے ماڈل چلانے کے لیے مزید جگہ ملتی ہے۔

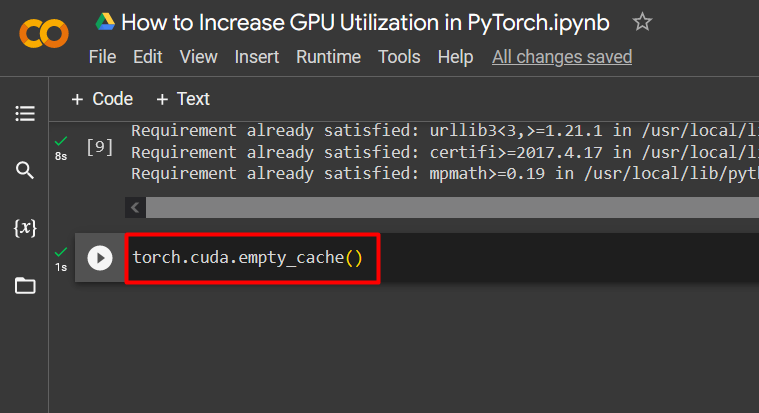

GPU کیشے کو صاف کرنے کی کمانڈ ذیل میں دی گئی ہے۔

ٹارچ مختلف . خالی_کیشے ( )

یہ تجاویز PyTorch میں GPUs کے ساتھ مشین لرننگ ماڈلز کے چلانے کو بہتر بنانے کے لیے استعمال کی جاتی ہیں۔

پرو ٹِپ

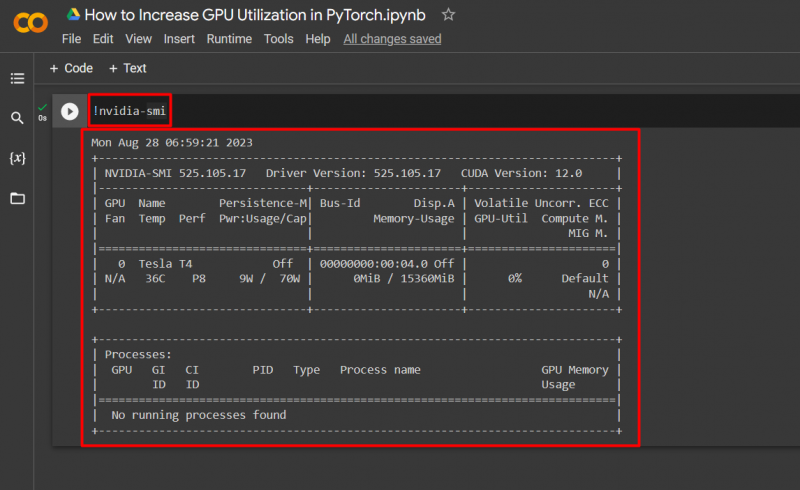

گوگل کولاب اپنے صارفین کو GPU کے استعمال کے بارے میں تفصیلات تک رسائی کی اجازت دیتا ہے۔ nvidia ہارڈ ویئر کے وسائل کہاں استعمال ہو رہے ہیں اس بارے میں معلومات حاصل کرنے کے لیے۔ GPU کے استعمال کی تفصیلات کو ظاہر کرنے کی کمانڈ ذیل میں دی گئی ہے:

! nvidia - smi

کامیابی! ہم نے ابھی PyTorch میں GPU کے استعمال کو بڑھانے کے چند طریقے دکھائے ہیں۔

نتیجہ

PyTorch میں کیشے کو حذف کرکے، PyTorch Lightning کا استعمال کرتے ہوئے، رن ٹائم سیٹنگز کو ایڈجسٹ کرکے، موثر ماڈلز کا استعمال کرکے، اور بہترین بیچ کے سائز کے ذریعے PyTorch میں GPU کے استعمال میں اضافہ کریں۔ یہ تکنیکیں اس بات کو یقینی بنانے میں ایک طویل سفر طے کرتی ہیں کہ گہرے سیکھنے کے ماڈل اپنی بہترین کارکردگی کا مظاہرہ کرتے ہیں اور دستیاب اعداد و شمار سے درست نتائج اور نتائج اخذ کرنے کے قابل ہیں۔ ہم نے GPU کے استعمال کو بڑھانے کی تکنیکوں کا مظاہرہ کیا ہے۔