نحو:

جیسا کہ ہم ChatGPT سے واقف ہیں، ہم جانتے ہیں کہ یہ پلیٹ فارم اوپن AI کمیونٹی کی ملکیت ہے اور یہ ٹولز، آرکیٹیکچرز، APIs، اور کئی فریم ورک فراہم کرتا ہے جنہیں ہم اپنی ایپلی کیشنز اور قدرتی زبان کے پروسیسنگ ماڈلز کی تعیناتی میں استعمال کر سکتے ہیں۔ Open AI وہ APIs پیش کرتا ہے جس کے ذریعے ہم اوپن AI پلیٹ فارم سے پہلے سے تربیت یافتہ AI اور NLP ماڈل استعمال کر سکتے ہیں اور انہیں ہماری ایپلی کیشنز کے لیے کام کر سکتے ہیں، مثال کے طور پر، ریئل ٹائم ڈیٹا پر پیشین گوئیاں دینا۔ اسی طرح، GPT4All اپنے صارفین کو اپنے پہلے سے تربیت یافتہ AI ماڈلز کو مختلف ایپلی کیشنز کے ساتھ مربوط کرنے کے لیے بھی فراہم کرتا ہے۔

ChatGPT کے مقابلے GPT4All ماڈل کو محدود ڈیٹا پر تربیت دی جاتی ہے۔ چیٹ جی پی ٹی کے مقابلے میں اس کی کارکردگی کی کچھ رکاوٹیں بھی ہیں لیکن یہ صارف کو اپنے مقامی ہارڈ ویئر پر اپنا نجی جی پی ٹی استعمال کرنے کی اجازت دیتا ہے اور اس کے لیے کسی نیٹ ورک کنکشن کی ضرورت نہیں ہے۔ اس آرٹیکل کی مدد سے، ہم یہ جان سکیں گے کہ ہم Python اسکرپٹ میں GPT4All ماڈلز کو کس طرح استعمال کر سکتے ہیں کیونکہ GPT4All کی Python کے ساتھ باضابطہ پابندیاں ہیں جس کا مطلب ہے کہ ہم Python اسکرپٹ کے ذریعے GPT4All ماڈلز کو بھی استعمال اور انٹیگریٹ کر سکتے ہیں۔

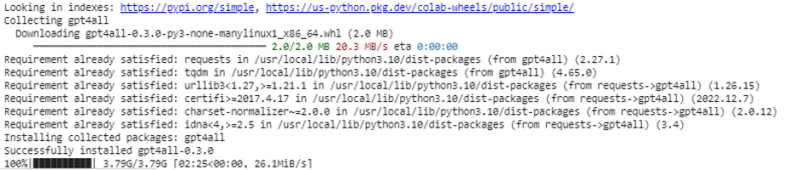

Python IDE کے لیے GPT4All انسٹال کرنے کے لیے یہ سب ایک آن لائن کمانڈ لیتا ہے۔ پھر، ہم اپنی ایپلی کیشنز کے طور پر زیادہ سے زیادہ AI ماڈلز کو ضم کر سکتے ہیں۔ Python میں GPT4All کو انسٹال کرنے کی کمانڈ مندرجہ ذیل میں دکھایا گیا ہے:

$pip انسٹال gpt4all

مثال 1:

اس مثال کے ساتھ شروع کرنے کے لیے، ہمیں اپنے سسٹمز میں ازگر کو ڈاؤن لوڈ اور انسٹال کرنے کی ضرورت ہے۔ Python کے تجویز کردہ ورژن 'ورژن 3.7' یا اس ورژن کے بعد آنے والے ورژن ہیں۔ ہمارے سسٹمز پر 'Python سیٹ اپ' کو انسٹال کرنے کے طویل عمل سے بچنے کے لیے Python کے ساتھ کام کرنے کا ایک اور طریقہ 'Google Colab' کا استعمال کرنا ہے جو Python کے لیے کلاؤڈ بیسڈ ماحول ہے۔ ہم اس ماحول کو کسی بھی ویب براؤزر پر چلا سکتے ہیں اور AI اور مشین لرننگ ماڈل بنا سکتے ہیں۔ جو مثالیں ہم یہاں نافذ کریں گے وہ گوگل کولاب میں لاگو ہوتی ہیں۔

اس مثال میں Python میں GPT4All انسٹال کرنے کے طریقہ کار اور اس کے پہلے سے تربیت یافتہ ماڈلز کو استعمال کرنے کا طریقہ شامل ہے۔ ہم سب سے پہلے GPT4All انسٹال کرکے شروع کرتے ہیں۔ اس کے لیے، وہ حکم جس کا ہم نے پہلے ذکر کیا ہے، عمل میں لایا جاتا ہے۔ کمانڈ کے نفاذ کے ساتھ، GPT4All اس کے پیکجز اور فریم ورک کے ساتھ ڈاؤن لوڈ اور انسٹال ہو جاتے ہیں۔

اب، ہم آگے بڑھتے ہیں. GPT4All سے، ہم 'GPT4All' درآمد کرتے ہیں۔ یہ GPT4All سے تمام پہلے سے تربیت یافتہ ماڈلز کو پروجیکٹ میں شامل کرتا ہے۔ اب، ہم کسی ایک ماڈل کو استعمال کر سکتے ہیں اور اسے اپنی درخواست کے لیے پیشین گوئیاں کر سکتے ہیں۔ ایک بار جب ہم GPT4All پیکیج درآمد کر لیتے ہیں، اب وقت آگیا ہے کہ اس فنکشن کو کال کریں اور GPT4All ماڈل استعمال کریں جو 'چیٹ کی تکمیل' کے لیے آؤٹ پٹ دیتا ہے۔

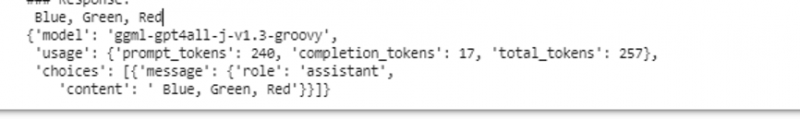

دوسرے الفاظ میں، اگر ہم ان پٹ میں اس ماڈل سے کچھ پوچھتے ہیں، تو یہ اسے آؤٹ پٹ میں واپس کر دیتا ہے۔ جو ماڈل ہم یہاں استعمال کرتے ہیں وہ ہے 'ggml-gpt4all-j-v1.3-groovy'۔ یہ ماڈل پہلے ہی GPT4All کیشے میں محفوظ ہیں۔ ہم یہ ماڈل اس لنک سے حاصل کر سکتے ہیں۔ https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat 'دستی ڈاؤن لوڈ کرنے کے لیے۔ اگر ماڈل پہلے سے ہی GPT4All کیشے میں موجود ہے، تو ہم صرف ماڈل کا نام کہتے ہیں اور اسے 'GPT4All()' فنکشن میں ان پٹ پیرامیٹرز کے طور پر بتاتے ہیں۔ اگر ہم اسے دستی طور پر کامیابی کے ساتھ ڈاؤن لوڈ کرتے ہیں، تو ہم اس فولڈر کا راستہ پاس کرتے ہیں جہاں ماڈل واقع ہے۔ چونکہ یہ ماڈل پیغام کی تکمیل کے لیے ہے، اس لیے اس ماڈل کا نحو درج ذیل ہے:

$ Chat_completion (پیغامات)پیغامات ایک لغت کی فہرست ہیں اور ہر لغت میں صارف، سسٹم، یا اسسٹنٹ کی قدر کے ساتھ ایک 'کردار' کلید اور 'کلید' مواد پر مشتمل ہونا چاہیے جس کی قدر سٹرنگ جیسی ہے۔ اس مثال میں، ہم مواد کو بطور 'تین رنگوں کا نام' اور رول کلید کو 'صارف' کے بطور متعین کرتے ہیں۔

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'کردار': 'صارف'، 'مواد': 'نام 3 پھول'}]

اس تفصیلات کے بعد، ہم ماڈل کے ساتھ 'chat_completion()' فنکشن کہتے ہیں۔ اس کے لیے کوڈ درج ذیل آؤٹ پٹ میں ظاہر ہوتا ہے۔

$ !pip انسٹال gpt4allgpt4all سے GPT4All درآمد کریں۔

ماڈل = GPT4All('ggml-gpt4all-j-v1.3-groovy')

پیغامات = [{'کردار': 'صارف'، 'مواد': 'تین رنگوں کے نام'}]

model.chat_completion(پیغامات)

اس مثال کے نفاذ کے بعد، ماڈل ان پٹ کے جواب کے طور پر تین رنگ واپس کرتا ہے۔

مثال 2:

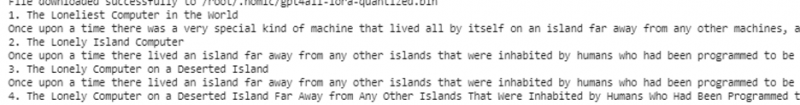

ہم ایک اور مثال کا احاطہ کرتے ہیں جہاں ہمیں Python میں GPT4All استعمال کرنے کا دوسرا طریقہ دریافت ہوتا ہے۔ یہ Python کے لیے آفیشل پابندیوں کا استعمال کرتے ہوئے کیا جا سکتا ہے جو کہ 'Nomic' کے ذریعے فراہم کی گئی ہے جو کہ ایک اوپن سورس AI کمیونٹی ہے، اور یہ GPT4All کو چلاتی ہے۔ درج ذیل کمانڈ کا استعمال کرتے ہوئے، ہم 'nomic' کو اپنے Python کنسول میں ضم کرتے ہیں۔

$pip install nomicاس کے انسٹال ہونے کے بعد، ہم 'nomic.gpt4all' سے GPT4All درآمد کرتے ہیں۔ GPT4All درآمد کرنے کے بعد، ہم GPT4All کو 'اوپن()' فنکشن کے ساتھ شروع کرتے ہیں۔ پھر، ہم 'prompt()' فنکشن کو کال کرتے ہیں اور اس فنکشن کو پرامپٹ پاس کرتے ہیں۔ اس کے بعد، فوری جواب اس پرامپٹ کی بنیاد پر تیار کیا جاتا ہے جو ہم نے پرامپٹ ماڈل میں بطور ان پٹ دیا ہے۔

!pip install nomicnomic.gpt4all سے GPT4All درآمد کریں۔

# GPT4All ماڈل کو شروع کریں۔

initiate = GPT4All()

initiate.open()

# پرامپٹ کی بنیاد پر جواب تیار کرنا

model_response = initiate.prompt ('کمپیوٹر کے بارے میں ایک مختصر کہانی لکھیں)

# پیدا کردہ جواب کو ظاہر کرنا

پرنٹ (ماڈل_جواب)

آؤٹ پٹ اس ماڈل سے فوری جواب دکھاتا ہے جو ہم نے Python میں پہلے سے تربیت یافتہ GPT4All ماڈل کا استعمال کرتے ہوئے تیار کیا تھا۔ اگر ہم ماڈلز کے بارے میں مزید جاننا چاہتے ہیں اور جوابات پیدا کرنے کے لیے ہم ان ماڈلز کو کس طرح استعمال کر سکتے ہیں، یا آسان الفاظ میں، اگر ہم ان ماڈلز سے ردعمل پیدا کرنے کے لیے نحو کے بارے میں علم حاصل کرنا چاہتے ہیں، تو ہم مزید مدد لے سکتے ہیں۔ GPT4تمام تکنیکی دستاویزات کی تفصیلات۔

نتیجہ

GPT4All اب بھی کارکردگی کی درستگی حاصل کرنے کے لیے کوشاں ہے۔ یہ نامک AI پلیٹ فارم کے ذریعے چلایا جاتا ہے جس کا مقصد صارفین کو صارف کے درجے کے CPUs پر مصنوعی طور پر ذہین چیٹ بوٹس فراہم کرنا ہے کیونکہ GPT4All بغیر کسی نیٹ ورک کنکشن اور GPUs کے کام کرتا ہے۔ یہ مضمون ہمیں PyGPT4All کو Python ماحول میں مہارت کے ساتھ استعمال کرنے اور ہماری ایپلی کیشنز اور پہلے سے تربیت یافتہ GPT4All AI ماڈلز کے درمیان تعامل پیدا کرنے کے لیے روشن کرتا ہے۔ ہم نے اس گائیڈ میں Python میں GPT4All کو انسٹال کرنے کے بارے میں دو مختلف طریقوں کا احاطہ کیا۔