فوری آؤٹ لائن

یہ پوسٹ درج ذیل کو ظاہر کرے گی:

- لینگ چین میں اوپن اے آئی فنکشنز ایجنٹ میں میموری کیسے شامل کریں۔

- مرحلہ 1: فریم ورک انسٹال کرنا

- مرحلہ 2: ماحول کو ترتیب دینا

- مرحلہ 3: لائبریریاں درآمد کرنا

- مرحلہ 4: ڈیٹا بیس بنانا

- مرحلہ 5: ڈیٹا بیس اپ لوڈ کرنا

- مرحلہ 6: زبان کا ماڈل ترتیب دینا

- مرحلہ 7: میموری شامل کرنا

- مرحلہ 8: ایجنٹ کو شروع کرنا

- مرحلہ 9: ایجنٹ کی جانچ کرنا

- نتیجہ

لینگ چین میں اوپن اے آئی فنکشنز ایجنٹ میں میموری کو کیسے شامل کیا جائے؟

OpenAI ایک مصنوعی ذہانت (AI) تنظیم ہے جو 2015 میں بنائی گئی تھی اور شروع میں ایک غیر منافع بخش تنظیم تھی۔ مائیکروسافٹ 2020 سے بہت ساری خوش قسمتی کی سرمایہ کاری کر رہا ہے کیونکہ AI کے ساتھ نیچرل لینگویج پروسیسنگ (NLP) چیٹ بوٹس اور لینگویج ماڈلز کے ساتھ عروج پر ہے۔

OpenAI ایجنٹوں کی تعمیر ڈویلپرز کو انٹرنیٹ سے زیادہ پڑھنے کے قابل اور ٹو دی پوائنٹ نتائج حاصل کرنے کے قابل بناتی ہے۔ ایجنٹوں میں میموری شامل کرنے سے وہ چیٹ کے سیاق و سباق کو بہتر طریقے سے سمجھ سکتے ہیں اور پچھلی گفتگو کو بھی اپنی میموری میں محفوظ کر سکتے ہیں۔ LangChain میں OpenAI فنکشنز ایجنٹ میں میموری کو شامل کرنے کے عمل کو جاننے کے لیے، بس درج ذیل مراحل سے گزریں:

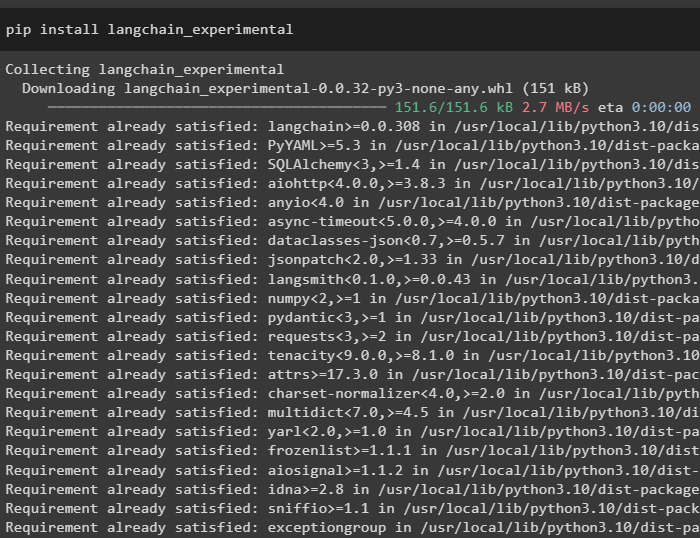

مرحلہ 1: فریم ورک انسٹال کرنا

سب سے پہلے، سے LangChain انحصار انسٹال کریں۔ 'لنگچین تجرباتی' درج ذیل کوڈ کا استعمال کرتے ہوئے فریم ورک:

pip انسٹال langchain - تجرباتی

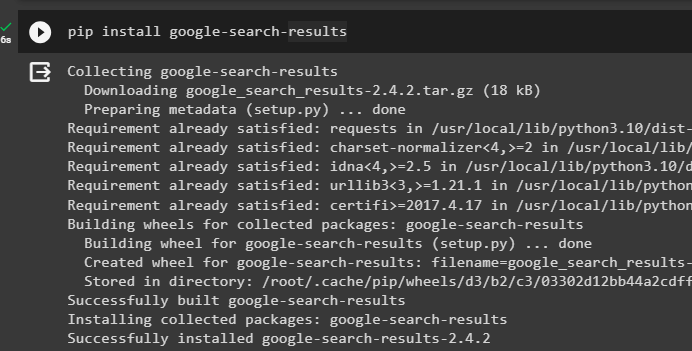

انسٹال کریں۔ گوگل سرچ کے نتائج گوگل سرور سے تلاش کے نتائج حاصل کرنے کے لیے ماڈیول:

pip گوگل انسٹال کریں۔ - تلاش کریں - نتائج

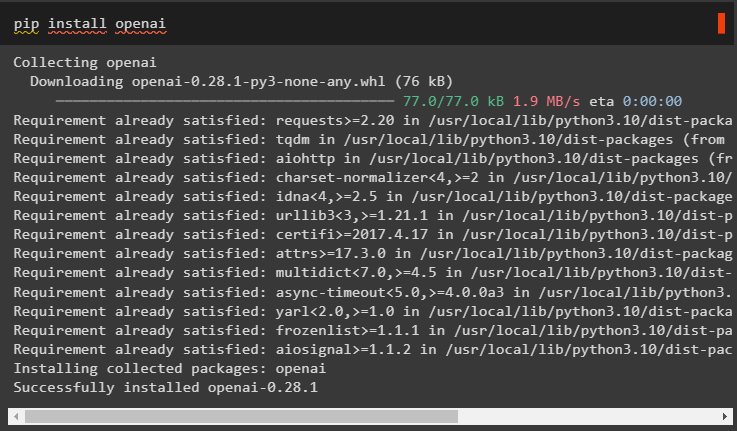

اس کے علاوہ، OpenAI ماڈیول انسٹال کریں جو LangChain میں زبان کے ماڈلز بنانے کے لیے استعمال کیا جا سکتا ہے:

پائپ انسٹال اوپنائی

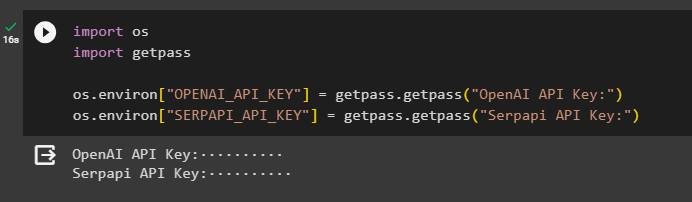

مرحلہ 2: ماحول کو ترتیب دینا

ماڈیولز حاصل کرنے کے بعد، سے API کیز کا استعمال کرتے ہوئے ماحول کو ترتیب دیں۔ اوپن اے آئی اور سرپاپی اکاؤنٹس:

درآمد تمدرآمد گیٹ پاس

تم. تقریباً [ 'OPENAI_API_KEY' ] = گیٹ پاس گیٹ پاس ( 'اوپن اے آئی API کلید:' )

تم. تقریباً [ 'SERPAPI_API_KEY' ] = گیٹ پاس گیٹ پاس ( 'Serpapi API کلید:' )

دونوں ماحول تک رسائی کے لیے API کیز داخل کرنے کے لیے مذکورہ کوڈ پر عمل کریں اور تصدیق کے لیے انٹر دبائیں:

مرحلہ 3: لائبریریاں درآمد کرنا

اب جب کہ سیٹ اپ مکمل ہو گیا ہے، میموری اور ایجنٹس کی تعمیر کے لیے مطلوبہ لائبریریوں کو درآمد کرنے کے لیے LangChain سے انسٹال کردہ انحصار کا استعمال کریں:

langchain سے. زنجیریں درآمد ایل ایل ایم میتھ چینlangchain سے. ایل ایم ایس درآمد اوپن اے آئی

انٹرنیٹ پر گوگل سے تلاش کرنے کے لیے #لائبریری حاصل کریں۔

langchain سے. افادیت درآمد SerpAPIWrapper

langchain سے. افادیت درآمد ایس کیو ایل ڈیٹا بیس

langchain_experimental سے۔ ایس کیو ایل درآمد ایس کیو ایل ڈیٹا بیس چین

# ٹولز بنانے کے لیے لائبریری حاصل کریں۔ کے لیے ایجنٹ کو شروع کرنا

langchain سے. ایجنٹس درآمد ایجنٹ کی قسم , ٹول , ابتدائیہ_ایجنٹ

langchain سے. چیٹ_ماڈلز درآمد چیٹ اوپن اے آئی

مرحلہ 4: ڈیٹا بیس بنانا

اس گائیڈ کے ساتھ آگے بڑھنے کے لیے، ہمیں ڈیٹا بیس بنانا ہوگا اور اس سے جوابات حاصل کرنے کے لیے ایجنٹ سے جڑنا ہوگا۔ ڈیٹا بیس بنانے کے لیے، اس کا استعمال کرتے ہوئے SQLite کو ڈاؤن لوڈ کرنے کی ضرورت ہے۔ رہنما اور درج ذیل کمانڈ کا استعمال کرتے ہوئے انسٹالیشن کی تصدیق کریں:

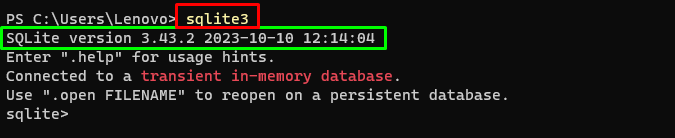

sqlite3میں مندرجہ بالا کمانڈ کو چلانا ونڈوز ٹرمینل SQLite کا انسٹال شدہ ورژن دکھاتا ہے۔ (3.43.2):

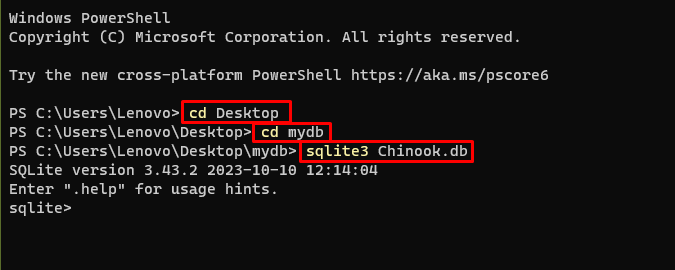

اس کے بعد، اپنے کمپیوٹر کی ڈائرکٹری میں جائیں جہاں ڈیٹا بیس بنایا اور محفوظ کیا جائے گا:

سی ڈی ڈیسک ٹاپcd mydb

sqlite3 چنوک۔ ڈی بی

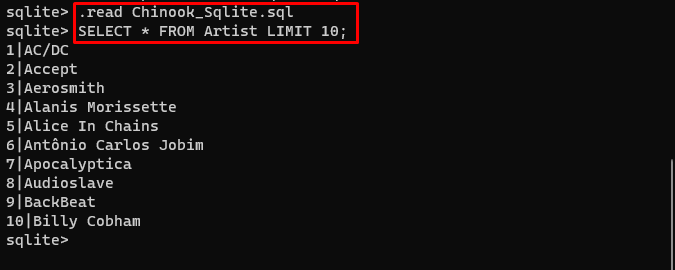

صارف اس سے ڈیٹا بیس کے مواد کو آسانی سے ڈاؤن لوڈ کر سکتا ہے۔ لنک ڈائرکٹری میں اور ڈیٹا بیس بنانے کے لیے درج ذیل کمانڈ پر عمل کریں:

. پڑھیں Chinook_Sqlite. ایس کیو ایلمنتخب کریں۔ * فنکار کی حد سے 10 ;

ڈیٹا بیس کو کامیابی کے ساتھ بنایا گیا ہے اور صارف مختلف سوالات کا استعمال کرتے ہوئے اس سے ڈیٹا تلاش کر سکتا ہے۔

مرحلہ 5: ڈیٹا بیس اپ لوڈ کرنا

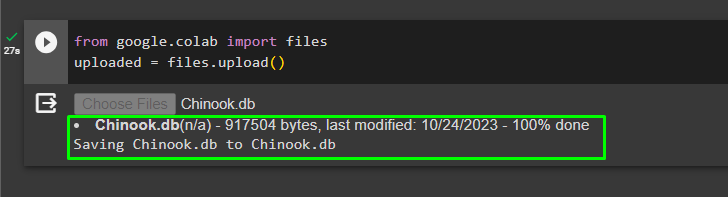

ایک بار جب ڈیٹا بیس کامیابی سے بن جائے تو اپ لوڈ کریں۔ '.db' درج ذیل کوڈ کا استعمال کرتے ہوئے Google Colaboratory میں فائل کریں:

گوگل سے ET رحمہ اللہ تعالی درآمد فائلوںاپ لوڈ = فائلوں. اپ لوڈ کریں ( )

پر کلک کرکے مقامی نظام سے فائل کا انتخاب کریں۔ 'فائلوں کا انتخاب کریں' مندرجہ بالا کوڈ پر عمل کرنے کے بعد بٹن:

ایک بار فائل اپ لوڈ ہونے کے بعد، صرف فائل کا راستہ کاپی کریں جو اگلے مرحلے میں استعمال کیا جائے گا:

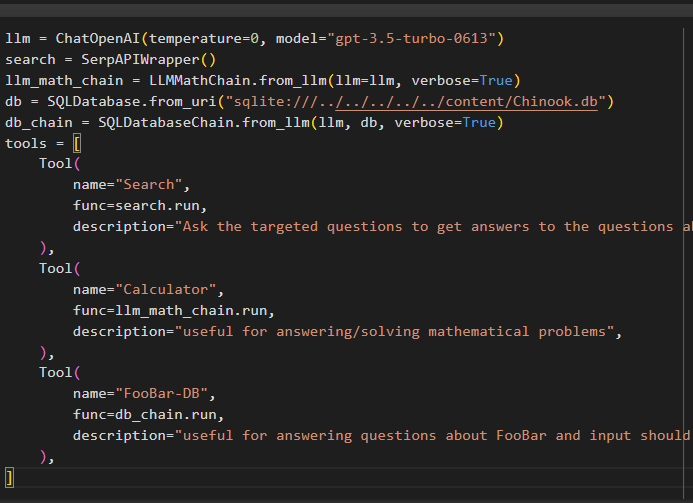

مرحلہ 6: زبان کا ماڈل ترتیب دینا

درج ذیل کوڈ کا استعمال کرتے ہوئے لینگویج ماڈل، چینز، ٹولز اور چینز بنائیں:

ایل ایل ایم = چیٹ اوپن اے آئی ( درجہ حرارت = 0 , ماڈل = 'gpt-3.5-turbo-0613' )تلاش کریں = SerpAPIWrapper ( )

llm_math_chain = ایل ایل ایم میتھ چین۔ سے_llm ( ایل ایل ایم = ایل ایل ایم , لفظی = سچ ہے۔ )

ڈی بی = ایس کیو ایل ڈیٹا بیس۔ سے_uri ( 'sqlite:///../../../../../content/Chinook.db' )

db_chain = ایس کیو ایل ڈیٹا بیس چین۔ سے_llm ( ایل ایل ایم , ڈی بی , لفظی = سچ ہے۔ )

اوزار = [

ٹول (

نام = 'تلاش' ,

func = تلاش کریں رن ,

تفصیل = 'حالیہ امور کے بارے میں سوالات کے جوابات حاصل کرنے کے لیے ٹارگٹڈ سوالات پوچھیں' ,

) ,

ٹول (

نام = 'کیلکولیٹر' ,

func = llm_math_chain رن ,

تفصیل = 'ریاضی کے مسائل کا جواب دینے/حل کرنے کے لیے مفید' ,

) ,

ٹول (

نام = 'FooBar-DB' ,

func = db_chain. رن ,

تفصیل = 'FooBar کے بارے میں سوالات کے جوابات دینے کے لیے مفید اور ان پٹ ایک سوال کی شکل میں ہونا چاہیے جس میں مکمل سیاق و سباق موجود ہو' ,

) ,

]

- دی ایل ایل ایم متغیر میں ماڈل کے نام کے ساتھ ChatOpenAI() طریقہ استعمال کرتے ہوئے زبان کے ماڈل کی تشکیلات شامل ہیں۔

- تلاش متغیر میں ایجنٹ کے لیے ٹولز بنانے کے لیے SerpAPIWrapper() طریقہ ہوتا ہے۔

- کی تعمیر کریں llm_math_chain LLMMathChain() طریقہ استعمال کرتے ہوئے ریاضی کے ڈومین سے متعلق جوابات حاصل کرنے کے لیے۔

- ڈی بی متغیر میں فائل کا راستہ ہوتا ہے جس میں ڈیٹا بیس کا مواد ہوتا ہے۔ صارف کو صرف آخری حصہ تبدیل کرنے کی ضرورت ہے۔ 'content/Chinook.db' رکھنے کے راستے کی 'sqlite:///../../../../../' ایسا ہی.

- کا استعمال کرتے ہوئے ڈیٹا بیس سے سوالات کے جوابات دینے کے لیے ایک اور سلسلہ بنائیں db_chain متغیر

- جیسے ٹولز کو ترتیب دیں۔ تلاش کریں , کیلکولیٹر ، اور FooBar-DB جواب تلاش کرنے، ریاضی کے سوالات کے جوابات، اور ڈیٹا بیس سے سوالات کے بالترتیب:

مرحلہ 7: میموری شامل کرنا

OpenAI فنکشنز کو کنفیگر کرنے کے بعد، بس میموری کو ایجنٹ میں بنائیں اور شامل کریں:

langchain سے. اشارہ کرتا ہے درآمد پیغامات پلیس ہولڈرlangchain سے. یاداشت درآمد گفتگو بفر میموری

ایجنٹ_کوارگز = {

'extra_prompt_messages' : [ پیغامات پلیس ہولڈر ( متغیر_نام = 'یاداشت' ) ] ,

}

یاداشت = گفتگو بفر میموری ( میموری_کی = 'یاداشت' , واپسی_پیغامات = سچ ہے۔ )

مرحلہ 8: ایجنٹ کو شروع کرنا

بنانے اور شروع کرنے کے لیے آخری جزو ایجنٹ ہے، جس میں تمام اجزاء شامل ہیں۔ ایل ایل ایم , ٹول , OPENAI_FUNCTIONS ، اور دیگر اس عمل میں استعمال کیے جائیں گے:

ایجنٹ = ابتدائیہ_ایجنٹ (اوزار ,

ایل ایل ایم ,

ایجنٹ = ایجنٹ کی قسم۔ OPENAI_FUNCTIONS ,

لفظی = سچ ہے۔ ,

ایجنٹ_کوارگز = ایجنٹ_کوارگز ,

یاداشت = یاداشت ,

)

مرحلہ 9: ایجنٹ کی جانچ کرنا

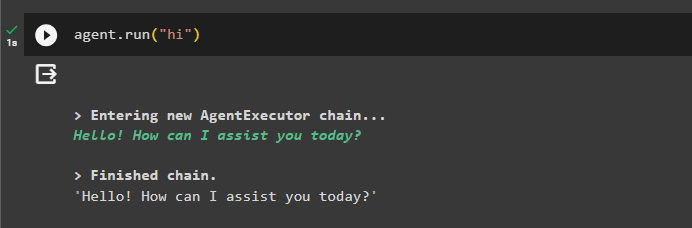

آخر میں، 'کا استعمال کرتے ہوئے چیٹ شروع کرکے ایجنٹ کی جانچ کریں۔ ہیلو پیغام:

ایجنٹ رن ( 'ہیلو' )

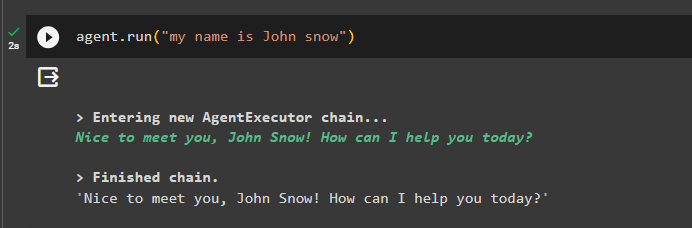

اس کے ساتھ ایجنٹ کو چلا کر میموری میں کچھ معلومات شامل کریں:

ایجنٹ رن ( 'میرا نام جان برف ہے' )

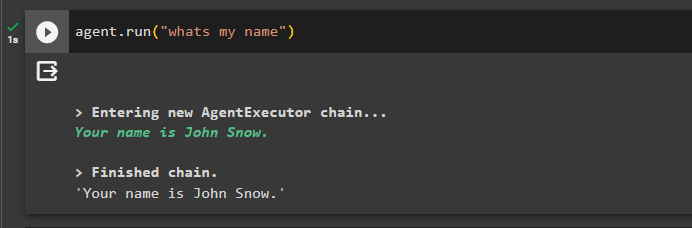

اب، پچھلی چیٹ کے بارے میں سوال پوچھ کر میموری کی جانچ کریں:

ایجنٹ رن ( 'میرا نام کیا ہے' )ایجنٹ نے میموری سے حاصل کردہ نام کے ساتھ جواب دیا ہے لہذا ایجنٹ کے ساتھ میموری کامیابی سے چل رہی ہے:

ابھی کے لیے اتنا ہی ہے۔

نتیجہ

LangChain میں OpenAI فنکشن ایجنٹ میں میموری کو شامل کرنے کے لیے، لائبریریوں کو درآمد کرنے کے لیے انحصار حاصل کرنے کے لیے ماڈیولز انسٹال کریں۔ اس کے بعد، بس ڈیٹا بیس بنائیں اور اسے Python نوٹ بک پر اپ لوڈ کریں تاکہ اسے ماڈل کے ساتھ استعمال کیا جا سکے۔ ماڈل، ٹولز، چینز، اور ڈیٹا بیس کو ایجنٹ میں شامل کرنے سے پہلے ترتیب دیں اور اسے شروع کریں۔ میموری کی جانچ کرنے سے پہلے، ConversationalBufferMemory() کا استعمال کرتے ہوئے میموری بنائیں اور اسے جانچنے سے پہلے ایجنٹ میں شامل کریں۔ اس گائیڈ نے LangChain میں OpenAI فنکشنز ایجنٹ میں میموری کو شامل کرنے کے بارے میں تفصیل سے بتایا ہے۔