یہ گائیڈ LangChain میں ہستی میموری استعمال کرنے کے عمل کی وضاحت کرے گا۔

LangChain میں ہستی میموری کا استعمال کیسے کریں؟

ہستی کا استعمال اہم حقائق کو میموری میں ذخیرہ کرنے کے لیے استعمال کیا جاتا ہے جب انسان سوالات/ اشارے کا استعمال کرتے ہوئے پوچھتا ہے۔ LangChain میں ہستی میموری کو استعمال کرنے کا طریقہ سیکھنے کے لیے، بس درج ذیل گائیڈ ملاحظہ کریں:

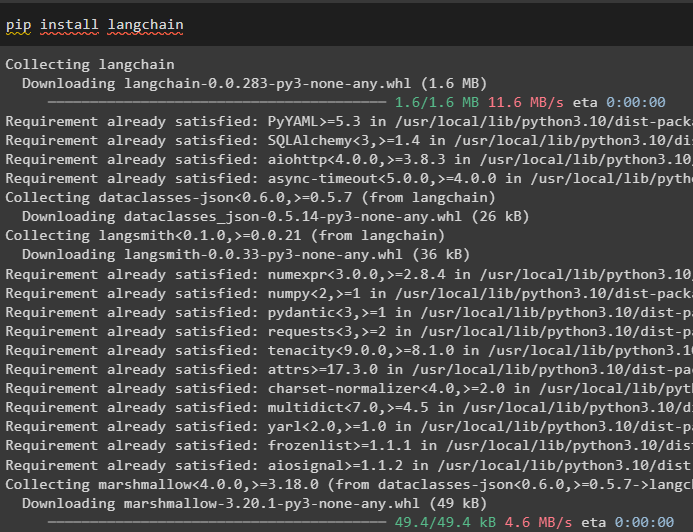

مرحلہ 1: ماڈیولز انسٹال کریں۔

سب سے پہلے، لینگ چین ماڈیول انسٹال کریں pip کمانڈ کا استعمال کرتے ہوئے اس کا انحصار حاصل کریں:

pip انسٹال langchain

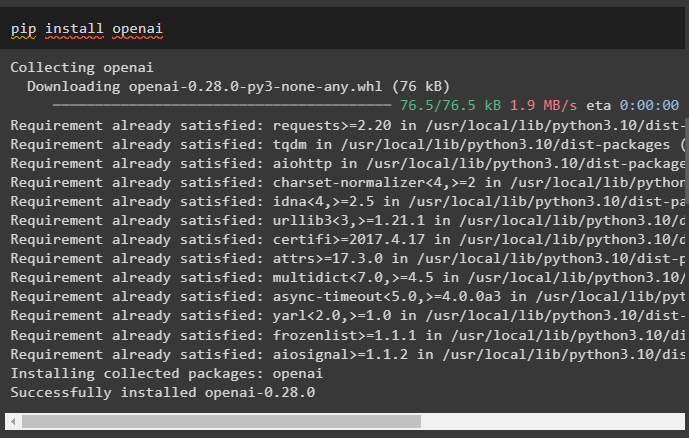

اس کے بعد، LLMs اور چیٹ ماڈلز بنانے کے لیے اس کی لائبریریاں حاصل کرنے کے لیے OpenAI ماڈیول انسٹال کریں:

پائپ انسٹال اوپنائی

اوپن اے آئی ماحول کو ترتیب دیں۔ API کلید کا استعمال کرتے ہوئے جسے OpenAI اکاؤنٹ سے نکالا جا سکتا ہے:

درآمد تم

درآمد گیٹ پاس

تم . تقریباً [ 'OPENAI_API_KEY' ] = گیٹ پاس . گیٹ پاس ( 'اوپن اے آئی API کلید:' )

مرحلہ 2: ہستی کی یادداشت کا استعمال

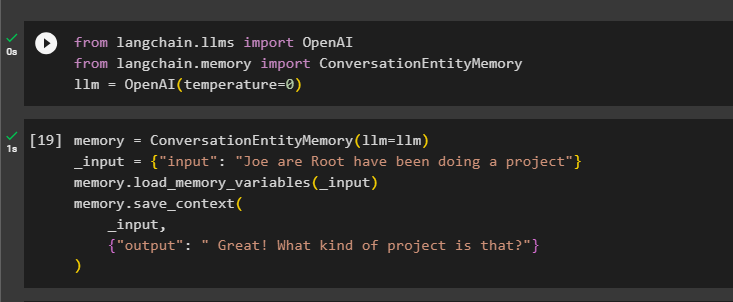

ہستی میموری کو استعمال کرنے کے لیے، OpenAI() طریقہ استعمال کرتے ہوئے LLM بنانے کے لیے مطلوبہ لائبریریاں درآمد کریں۔

سے langchain ایل ایم ایس درآمد اوپن اے آئیسے langchain یاداشت درآمد ConversationEntityMemory

ایل ایل ایم = اوپن اے آئی ( درجہ حرارت = 0 )

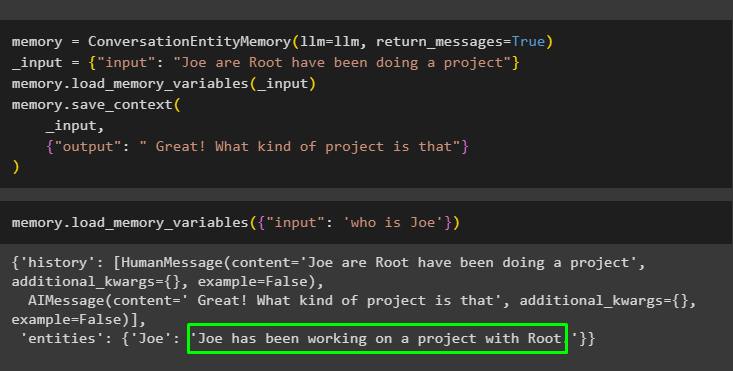

اس کے بعد، وضاحت کریں یاداشت ان پٹ اور آؤٹ پٹ متغیرات کا استعمال کرتے ہوئے ماڈل کو تربیت دینے کے لیے ConversationEntityMemory() طریقہ استعمال کرتے ہوئے متغیر:

یاداشت = ConversationEntityMemory ( ایل ایل ایم = ایل ایل ایم )_input = { 'ان پٹ' : 'جو روٹ ایک پروجیکٹ کر رہے ہیں' }

یاداشت. load_memory_variables ( _input )

یاداشت. سیویٹ_سیاق و سباق (

_input ,

{ 'آؤٹ پٹ' : 'بہت اچھا! یہ کیسا پروجیکٹ ہے؟' }

)

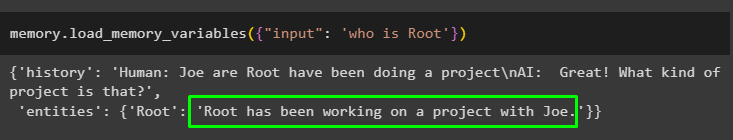

اب، میں استفسار/پرامپٹ کا استعمال کرتے ہوئے میموری کی جانچ کریں۔ ان پٹ load_memory_variables() طریقہ کو کال کرکے متغیر:

یاداشت. load_memory_variables ( { 'ان پٹ' : 'روٹ کون ہے' } )

اب، کچھ مزید معلومات دیں تاکہ ماڈل میموری میں کچھ اور ہستیوں کو شامل کر سکے۔

یاداشت = ConversationEntityMemory ( ایل ایل ایم = ایل ایل ایم , واپسی_پیغامات = سچ ہے۔ )_input = { 'ان پٹ' : 'جو روٹ ایک پروجیکٹ کر رہے ہیں' }

یاداشت. load_memory_variables ( _input )

یاداشت. سیویٹ_سیاق و سباق (

_input ,

{ 'آؤٹ پٹ' : 'بہت اچھا! یہ کیسا پروجیکٹ ہے؟' }

)

میموری میں ذخیرہ شدہ اداروں کا استعمال کرتے ہوئے آؤٹ پٹ حاصل کرنے کے لیے درج ذیل کوڈ پر عمل کریں۔ کے ذریعے ممکن ہے۔ ان پٹ پرامپٹ پر مشتمل:

یاداشت. load_memory_variables ( { 'ان پٹ' : 'جو کون ہے' } )

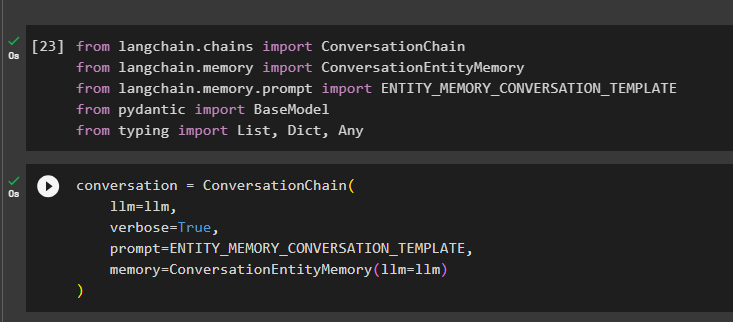

مرحلہ 3: ایک سلسلہ میں ہستی میموری کا استعمال

زنجیر بنانے کے بعد ہستی میموری کو استعمال کرنے کے لیے، درج ذیل کوڈ بلاک کا استعمال کرتے ہوئے مطلوبہ لائبریریاں درآمد کریں۔

سے langchain زنجیریں درآمد گفتگو کا سلسلہسے langchain یاداشت درآمد ConversationEntityMemory

سے langchain یاداشت . فوری طور پر درآمد ENTITY_MEMORY_CONVERSATION_TEMPLATE

سے پیڈینٹک درآمد بیس ماڈل

سے ٹائپنگ درآمد فہرست , ڈکٹ , کوئی بھی

llm جیسے دلائل کا استعمال کرتے ہوئے ConversationChain() طریقہ استعمال کرتے ہوئے گفتگو کا ماڈل بنائیں:

بات چیت = گفتگو کا سلسلہ (ایل ایل ایم = ایل ایل ایم ,

لفظی = سچ ہے۔ ,

فوری طور پر = ENTITY_MEMORY_CONVERSATION_TEMPLATE ,

یاداشت = ConversationEntityMemory ( ایل ایل ایم = ایل ایل ایم )

)

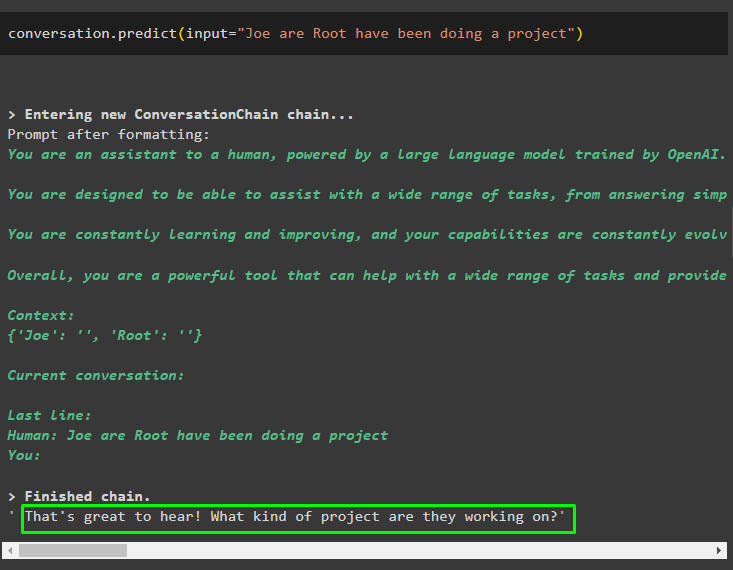

پرامپٹ یا استفسار کے ساتھ شروع کردہ ان پٹ کے ساتھ talk.predict() طریقہ کو کال کریں:

بات چیت پیشن گوئی ( ان پٹ = 'جو روٹ ایک پروجیکٹ کر رہے ہیں' )

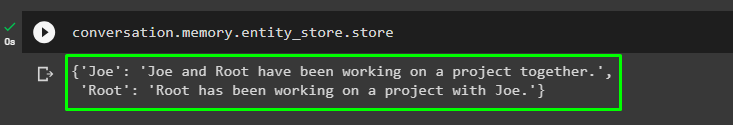

اب، اس کے بارے میں معلومات کو بیان کرنے والے ہر ادارے کے لیے علیحدہ آؤٹ پٹ حاصل کریں:

بات چیت یاداشت . entity_store . اسٹور

ان پٹ دینے کے لیے ماڈل سے آؤٹ پٹ کا استعمال کریں تاکہ ماڈل ان اداروں کے بارے میں مزید معلومات محفوظ کر سکے:

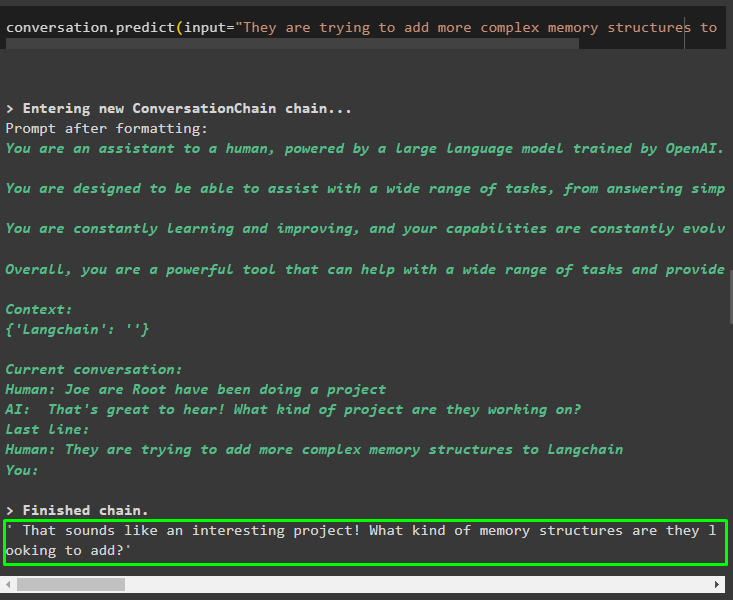

بات چیت پیشن گوئی ( ان پٹ = 'وہ لینگچین میں زیادہ پیچیدہ میموری ڈھانچے کو شامل کرنے کی کوشش کر رہے ہیں' )

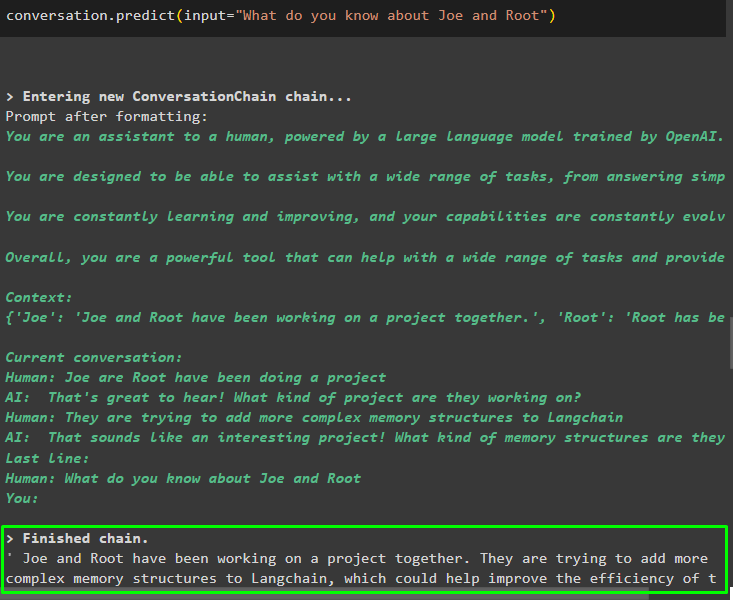

میموری میں محفوظ ہونے والی معلومات دینے کے بعد، اداروں کے بارے میں مخصوص معلومات نکالنے کے لیے صرف سوال پوچھیں:

بات چیت پیشن گوئی ( ان پٹ = 'آپ جو اور روٹ کے بارے میں کیا جانتے ہیں' )

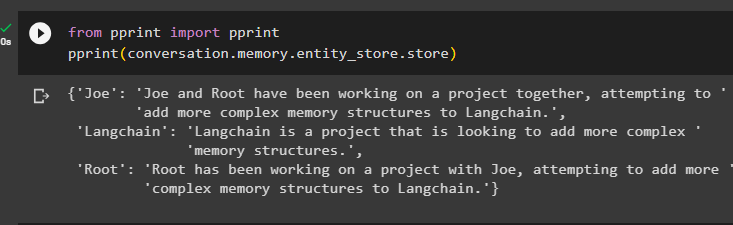

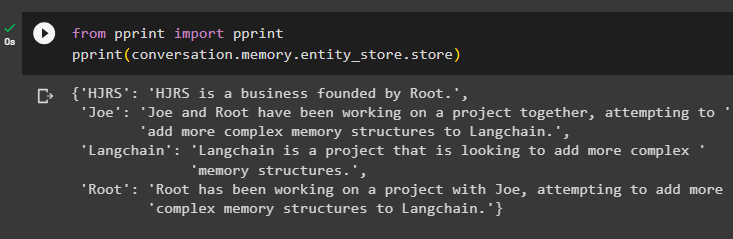

مرحلہ 4: میموری اسٹور کی جانچ کرنا

صارف مندرجہ ذیل کوڈ کا استعمال کرتے ہوئے میموری اسٹورز کا براہ راست معائنہ کر سکتا ہے تاکہ ان میں ذخیرہ شدہ معلومات حاصل کی جا سکے۔

سے پرنٹ کریں درآمد پرنٹ کریںپرنٹ کریں ( بات چیت یاداشت . entity_store . اسٹور )

میموری میں ذخیرہ کرنے کے لیے مزید معلومات فراہم کریں کیونکہ مزید معلومات زیادہ درست نتائج دیتی ہیں:

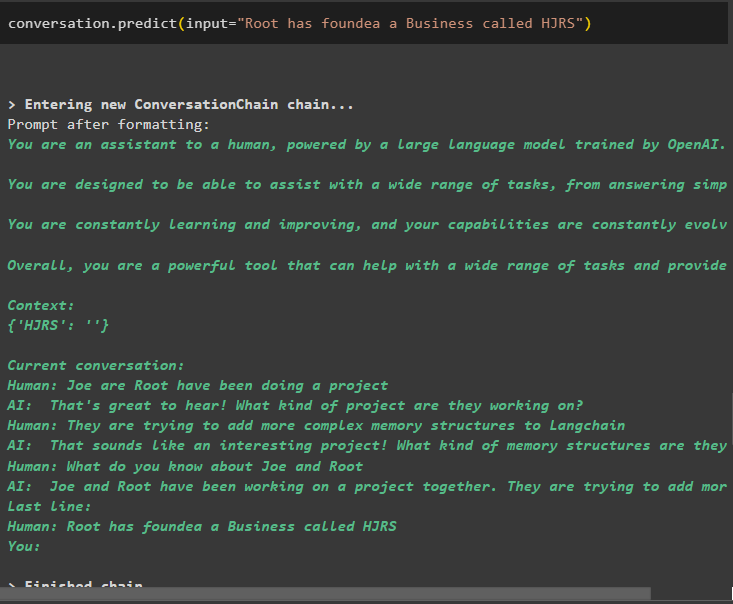

بات چیت پیشن گوئی ( ان پٹ = 'روٹ نے HJRS نامی کاروبار کی بنیاد رکھی ہے' )

اداروں کے بارے میں مزید معلومات شامل کرنے کے بعد میموری اسٹور سے معلومات نکالیں:

سے پرنٹ کریں درآمد پرنٹ کریںپرنٹ کریں ( بات چیت یاداشت . entity_store . اسٹور )

میموری میں متعدد اداروں جیسے HJRS، Joe، LangChain، اور Root کے بارے میں معلومات ہیں:

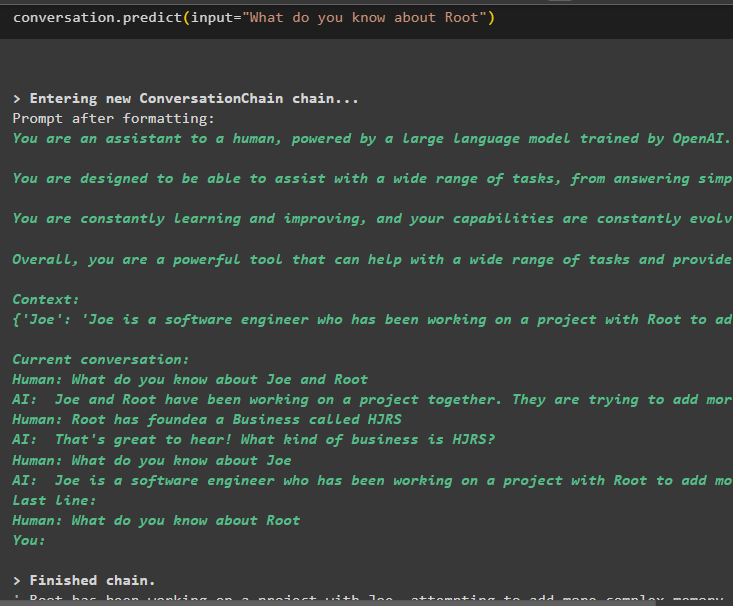

اب ان پٹ متغیر میں بیان کردہ استفسار یا پرامپٹ کا استعمال کرتے ہوئے کسی مخصوص ہستی کے بارے میں معلومات نکالیں:

بات چیت پیشن گوئی ( ان پٹ = 'آپ روٹ کے بارے میں کیا جانتے ہیں؟' )

یہ سب LangChain فریم ورک کا استعمال کرتے ہوئے ہستی میموری کو استعمال کرنے کے بارے میں ہے۔

نتیجہ

LangChain میں ہستی میموری کو استعمال کرنے کے لیے، OpenAI ماحول کو ترتیب دینے کے بعد ماڈلز بنانے کے لیے درکار لائبریریوں کو درآمد کرنے کے لیے صرف مطلوبہ ماڈیولز انسٹال کریں۔ اس کے بعد، LLM ماڈل بنائیں اور اداروں کے بارے میں معلومات فراہم کرکے میموری میں اداروں کو اسٹور کریں۔ صارف ان ہستیوں کا استعمال کرتے ہوئے معلومات بھی نکال سکتا ہے اور ہستیوں کے بارے میں ہلچل مچا کر ان یادوں کو زنجیروں میں باندھ سکتا ہے۔ اس پوسٹ نے LangChain میں ہستی میموری کو استعمال کرنے کے عمل کی وضاحت کی ہے۔