Hugging Face کی 'ڈیٹا سیٹس' لائبریری قدرتی زبان کی پروسیسنگ کے کاموں کے لیے ڈیٹاسیٹس کے ساتھ کام کرنے اور ان میں ہیرا پھیری کرنے کا ایک آسان طریقہ فراہم کرتی ہے۔ ایک مفید فنکشن جو لائبریری کے ذریعہ پیش کیا جاتا ہے وہ ہے concatenate_datasets() جو آپ کو متعدد ڈیٹاسیٹ کو ایک ہی ڈیٹاسیٹ میں جوڑنے کی اجازت دیتا ہے۔ ذیل میں concatenate_datasets() فنکشن کا ایک مختصر جائزہ اور اسے استعمال کرنے کا طریقہ ہے۔

concatenate_datasets()

تفصیل:

Hugging Face کی 'datasets' لائبریری concatenate_datasets() فنکشن فراہم کرتی ہے۔ اس کا استعمال متعدد ڈیٹاسیٹ کو ایک مخصوص محور کے ساتھ ایک واحد ڈیٹاسیٹ میں جوڑنے کے لیے کیا جاتا ہے۔ یہ فنکشن خاص طور پر اس وقت مفید ہے جب آپ کے پاس متعدد ڈیٹا سیٹس ہوں جو ایک ہی ڈھانچے کا اشتراک کرتے ہیں اور آپ انہیں مزید پروسیسنگ اور تجزیہ کے لیے ایک متحد ڈیٹاسیٹ میں ضم کرنا چاہتے ہیں۔

نحو:

سے ڈیٹاسیٹس درآمد concatenate_datasets

concatenated_dataset = concatenate_datasets ( ڈیٹاسیٹس , محور = 0 , معلومات = کوئی نہیں۔ )

پیرامیٹرز:

ڈیٹاسیٹس (ڈیٹا سیٹ کی فہرست): ڈیٹا سیٹس کی ایک فہرست جسے آپ جوڑنا چاہتے ہیں۔ ان ڈیٹاسیٹس میں مطابقت پذیر خصوصیات ہونی چاہئیں جس کا مطلب ہے کہ ان کے پاس ایک جیسے اسکیما، کالم کے نام اور ڈیٹا کی اقسام ہیں۔

محور (int, optional, default=0): وہ محور جس کے ساتھ کنکٹیشن کو انجام دیا جانا چاہیے۔ زیادہ تر NLP ڈیٹاسیٹس کے لیے، 0 کی ڈیفالٹ ویلیو استعمال کی جاتی ہے جس کا مطلب ہے کہ ڈیٹاسیٹس عمودی طور پر جڑے ہوئے ہیں۔ اگر آپ axis=1 سیٹ کرتے ہیں تو، ڈیٹاسیٹس کو افقی طور پر جوڑ دیا جاتا ہے، یہ فرض کرتے ہوئے کہ ان میں خصوصیات کے طور پر مختلف کالم ہیں۔

معلومات (datasets.DatasetInfo، اختیاری): مربوط ڈیٹاسیٹ کے بارے میں معلومات۔ اگر فراہم نہیں کی جاتی ہے، تو فہرست میں پہلے ڈیٹا سیٹ سے معلومات کا اندازہ لگایا جاتا ہے۔

واپسی:

concatenated_dataset (ڈیٹا سیٹ): تمام ان پٹ ڈیٹا سیٹس کو جوڑنے کے بعد نتیجے میں ڈیٹا سیٹ۔

مثال:

# مرحلہ 1: ڈیٹاسیٹس لائبریری انسٹال کریں۔# آپ اسے پائپ کا استعمال کرکے انسٹال کرسکتے ہیں:

# !pip انسٹال ڈیٹا سیٹس

# مرحلہ 2: مطلوبہ لائبریریاں درآمد کریں۔

سے ڈیٹاسیٹس درآمد لوڈ_ڈیٹا سیٹ , concatenate_datasets

#مرحلہ 3: IMDb مووی ریویو ڈیٹاسیٹ لوڈ کریں۔

# ہم دو IMDb ڈیٹا سیٹس استعمال کریں گے، ایک مثبت جائزوں کے لیے

#اور دوسرا منفی جائزوں کے لیے۔

# 2500 مثبت جائزے لوڈ کریں۔

dataset_pos = لوڈ_ڈیٹا سیٹ ( 'imdb' , تقسیم = 'ٹرین[:2500]' )

# 2500 منفی جائزے لوڈ کریں۔

dataset_neg = لوڈ_ڈیٹا سیٹ ( 'imdb' , تقسیم = 'ٹرین[-2500:]' )

# مرحلہ 4: ڈیٹاسیٹس کو جوڑیں۔

# ہم دونوں ڈیٹاسیٹس کو محور = 0 کے ساتھ جوڑتے ہیں، جیسا کہ ان کے پاس ہے۔

ایک ہی سکیما ( اسی خصوصیات ) .

concatenated_dataset = concatenate_datasets ( [ dataset_pos , dataset_neg ] )

# مرحلہ 5: مربوط ڈیٹاسیٹ کا تجزیہ کریں۔

# سادگی کے لیے، آئیے مثبت اور منفی کی تعداد شمار کرتے ہیں۔

مربوط ڈیٹاسیٹ میں # جائزے۔

مثبت_جائزوں کی تعداد = رقم ( 1 کے لیے لیبل میں

concatenated_dataset [ 'لیبل' ] اگر لیبل == 1 )

منفی_جائزوں کی تعداد = رقم ( 1 کے لیے لیبل میں

concatenated_dataset [ 'لیبل' ] اگر لیبل == 0 )

#مرحلہ 6: نتائج دکھائیں۔

پرنٹ کریں ( 'مثبت جائزوں کی تعداد:' , مثبت_جائزوں کی تعداد )

پرنٹ کریں ( 'منفی جائزوں کی تعداد:' , منفی_جائزوں کی تعداد )

# مرحلہ 7: مربوط ڈیٹاسیٹ سے چند مثالی جائزے پرنٹ کریں۔

پرنٹ کریں ( ' \n کچھ مثال کے جائزے:' )

کے لیے میں میں رینج ( 5 ) :

پرنٹ کریں ( f '{i + 1} کا جائزہ لیں: {concatenated_dataset['text'][i]}' )

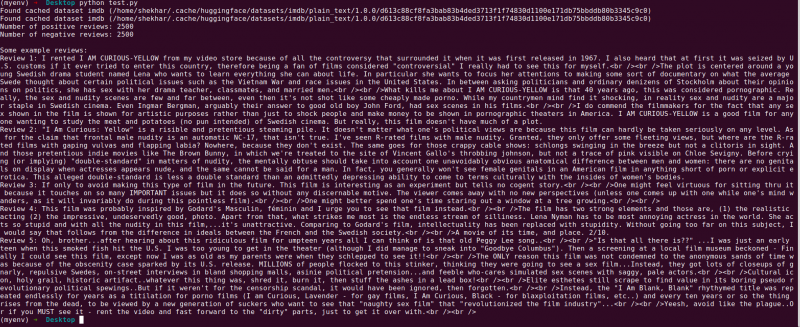

آؤٹ پٹ:

ذیل میں Hugging Face کے 'ڈیٹا سیٹس' لائبریری پروگرام کی وضاحت ہے جو دو IMDb مووی ریویو ڈیٹاسیٹس کو جوڑتا ہے۔ یہ پروگرام کے مقصد، اس کے استعمال اور کوڈ میں شامل اقدامات کی وضاحت کرتا ہے۔

آئیے کوڈ میں ہر قدم کی مزید تفصیلی وضاحت فراہم کرتے ہیں:

# مرحلہ 1: مطلوبہ لائبریریاں درآمد کریں۔سے ڈیٹاسیٹس درآمد لوڈ_ڈیٹا سیٹ , concatenate_datasets

اس مرحلے میں، ہم پروگرام کے لیے ضروری لائبریریاں درآمد کرتے ہیں۔ ہمیں IMDb مووی ریویو ڈیٹاسیٹس کو لوڈ کرنے کے لیے 'load_dataset' فنکشن اور بعد میں ان کو جوڑنے کے لیے 'concatenate_datasets' کی ضرورت ہے۔

# مرحلہ 2: IMDb مووی ریویو ڈیٹاسیٹس لوڈ کریں۔# 2500 مثبت جائزے لوڈ کریں۔

dataset_pos = لوڈ_ڈیٹا سیٹ ( 'imdb' , تقسیم = 'ٹرین[:2500]' )

# 2500 منفی جائزے لوڈ کریں۔

dataset_neg = لوڈ_ڈیٹا سیٹ ( 'imdb' , تقسیم = 'ٹرین[-2500:]' )

یہاں، ہم IMDb ڈیٹاسیٹ کے دو ذیلی سیٹوں کو حاصل کرنے کے لیے 'load_dataset' فنکشن استعمال کرتے ہیں۔ 'dataset_pos' میں 2500 مثبت جائزے ہیں اور 'dataset_neg' میں 2500 منفی جائزے ہیں۔ ہم اسپلٹ پیرامیٹر کو لوڈ کرنے کے لیے مثالوں کی حد کی وضاحت کرنے کے لیے استعمال کرتے ہیں جو ہمیں پورے ڈیٹاسیٹ کا سب سیٹ منتخب کرنے کی اجازت دیتا ہے۔

# مرحلہ 3: ڈیٹاسیٹس کو جوڑیں۔concatenated_dataset = concatenate_datasets ( [ dataset_pos , dataset_neg ] )

اس مرحلے میں، ہم IMDb ڈیٹاسیٹ کے دو ذیلی سیٹوں کو ایک واحد ڈیٹاسیٹ میں جوڑتے ہیں جسے 'concatenated_dataset' کہتے ہیں۔ ہم 'concatenate_datasets' فنکشن کا استعمال کرتے ہیں اور اسے ایک فہرست کے ساتھ پاس کرتے ہیں جس میں دو ڈیٹاسیٹس کو جوڑنا ہے۔ چونکہ دونوں ڈیٹاسیٹس میں ایک جیسی خصوصیات ہیں، اس لیے ہم انہیں محور = 0 کے ساتھ جوڑتے ہیں جس کا مطلب ہے کہ قطاریں ایک دوسرے کے اوپر رکھی ہوئی ہیں۔

# مرحلہ 4: مربوط ڈیٹاسیٹ کا تجزیہ کریں۔مثبت_جائزوں کی تعداد = رقم ( 1 کے لیے لیبل میں

concatenated_dataset [ 'لیبل' ] اگر لیبل == 1 )

منفی_جائزوں کی تعداد = رقم ( 1 کے لیے لیبل میں

concatenated_dataset [ 'لیبل' ] اگر لیبل == 0 )

یہاں، ہم مربوط ڈیٹاسیٹ کا ایک سادہ تجزیہ کرتے ہیں۔ ہم مثبت اور منفی جائزوں کی تعداد کو شمار کرنے کے لیے 'مجموعہ' فنکشن کے ساتھ فہرست کی تفہیم کا استعمال کرتے ہیں۔ ہم کے ذریعے اعادہ ' 'concatenated_dataset' کے کالم کو لیبل کریں اور جب بھی ہمیں کسی مثبت لیبل (1) یا منفی لیبل (0) کا سامنا ہو تو گنتی میں اضافہ کریں۔

# مرحلہ 5: نتائج دکھائیں۔پرنٹ کریں ( 'مثبت جائزوں کی تعداد:' ، مثبت_جائزوں کی تعداد )

پرنٹ کریں ( 'منفی جائزوں کی تعداد:' ، منفی_جائزوں کی تعداد )

اس مرحلے میں، ہم اپنے تجزیہ کے نتائج پرنٹ کرتے ہیں – مربوط ڈیٹاسیٹ میں مثبت اور منفی جائزوں کی تعداد۔

#مرحلہ 6: چند مثالوں کے جائزے پرنٹ کریں۔پرنٹ کریں ( ' \n کچھ مثال کے جائزے:' )

کے لیے میں میں رینج ( 5 ) :

پرنٹ کریں ( f '{i + 1} کا جائزہ لیں: {concatenated_dataset['text'][i]}' )

آخر میں، ہم مربوط ڈیٹاسیٹ سے چند مثالی جائزوں کی نمائش کرتے ہیں۔ ہم ڈیٹاسیٹ میں پہلی پانچ مثالوں کو لوپ کرتے ہیں اور 'ٹیکسٹ' کالم کا استعمال کرتے ہوئے ان کے متنی مواد کو پرنٹ کرتے ہیں۔

یہ کوڈ IMDb مووی ریویو ڈیٹاسیٹس کو لوڈ کرنے، جوڑنے اور ان کا تجزیہ کرنے کے لیے Hugging Face کی 'ڈیٹا سیٹس' لائبریری کو استعمال کرنے کی ایک سیدھی سی مثال ظاہر کرتا ہے۔ یہ لائبریری کی NLP ڈیٹاسیٹ ہینڈلنگ کو ہموار کرنے کی صلاحیت کو اجاگر کرتا ہے اور قدرتی لینگویج پروسیسنگ کے مزید جدید ماڈلز اور ایپلی کیشنز کی تعمیر کے لیے اپنی صلاحیت کو ظاہر کرتا ہے۔

نتیجہ

Python پروگرام جو Hugging Face کی 'ڈیٹا سیٹس' لائبریری کا استعمال کرتا ہے کامیابی کے ساتھ دو IMDb مووی ریویو ڈیٹاسیٹس کے اتحاد کو ظاہر کرتا ہے۔ مثبت اور منفی جائزوں کے ذیلی سیٹوں کو لوڈ کر کے، پروگرام concatenate_datasets() فنکشن کا استعمال کرتے ہوئے انہیں ایک ڈیٹاسیٹ میں یکجا کرتا ہے۔ اس کے بعد یہ مشترکہ ڈیٹاسیٹ میں مثبت اور منفی جائزوں کی تعداد گن کر ایک سادہ تجزیہ کرتا ہے۔

'ڈیٹا سیٹس' لائبریری NLP ڈیٹاسیٹس کو ہینڈل کرنے اور ان میں ہیرا پھیری کے عمل کو آسان بناتی ہے، جو اسے محققین، ڈویلپرز، اور NLP پریکٹیشنرز کے لیے ایک طاقتور ٹول بناتی ہے۔ اس کے صارف دوست انٹرفیس اور وسیع فنکشنلٹیز کے ساتھ، لائبریری ایک آسان ڈیٹا پری پروسیسنگ، ایکسپلوریشن اور تبدیلی کو قابل بناتی ہے۔ اس دستاویز میں جو پروگرام دکھایا گیا ہے وہ اس بات کی ایک عملی مثال کے طور پر کام کرتا ہے کہ ڈیٹا کنیکٹنیشن اور تجزیہ کے کاموں کو ہموار کرنے کے لیے لائبریری کو کس طرح فائدہ اٹھایا جا سکتا ہے۔

حقیقی زندگی کے منظرناموں میں، یہ پروگرام قدرتی لینگویج پروسیسنگ کے زیادہ پیچیدہ کاموں جیسے جذبات کا تجزیہ، متن کی درجہ بندی، اور زبان کی ماڈلنگ کے لیے ایک بنیاد کے طور پر کام کر سکتا ہے۔ 'ڈیٹا سیٹس' لائبریری کا استعمال کرتے ہوئے، محققین اور ڈویلپرز بڑے پیمانے پر ڈیٹا سیٹس کا مؤثر طریقے سے انتظام کر سکتے ہیں، تجربات کو آسان بنا سکتے ہیں، اور جدید ترین NLP ماڈلز کی ترقی کو تیز کر سکتے ہیں۔ مجموعی طور پر، ہگنگ فیس 'ڈیٹا سیٹس' لائبریری قدرتی زبان کی پروسیسنگ اور تفہیم میں ترقی کے حصول میں ایک ضروری اثاثہ کے طور پر کھڑی ہے۔